안녕하세요 성미느입니다.

KMOOC 홍보대사로 활동하면서 수원대학교 강의인 '인공지능 HRI'를 틈나는 대로 듣고 있습니다. 이번에는 3주 차 강의를 듣고 나서 강의 내용 정리 및 후기글입니다.

이번 주 강의는 딥러닝 모델 최적화 방법과 인공지능이 어떻게 학습하는지에 대해 중점적으로 배웠음.

강의내용 정리

3-1 딥러닝의 기초이론 및 수학적 표현

저번 강의에서 딥러닝은 분류, 회귀, 문제 검출의 일을 할 수 있었다고 배웠다.

분류 문제는 큰 범주인 동물에서 개, 고양이, 돼지 등을 분류하거나 자동차, 비행기 등을 분류하는 문제를 해결한다.

회귀 문제는 함수적인 관계가 있을 때, 인공지능을 통해서 풀어내는 문제다.

회귀에서 자주 사용하는 단어로 선형 회귀, 평균 제곱 오차가 있다. '선형 회귀'는 1차 함수로서 데이터의 특징을 가장 잘 표현하는 선형식을 찾는 동작이다. 그러나 실제 딥러닝에서 가장 많이 사용하는 것은 다중 선형 회귀임.

'평균 제곱 오차'는 인공지능이 계산할 때 오차 값이 다르게 바뀌므로 평균을 내야 함. 따라서 오차 값의 순수한 오차 값만 계산해낼 수 있도록 만들어 낸 것! 예를 들어 인공지능에게 "나는 키 170cm, 몸무게는 65kg"라고 학습을 시켜주고 인공지능이 학습 알고리즘과 회귀 문제를 가지고 계산을 해내도록 시켰을 시 실제로 다르게 나오는 값을 오차값이라 함.

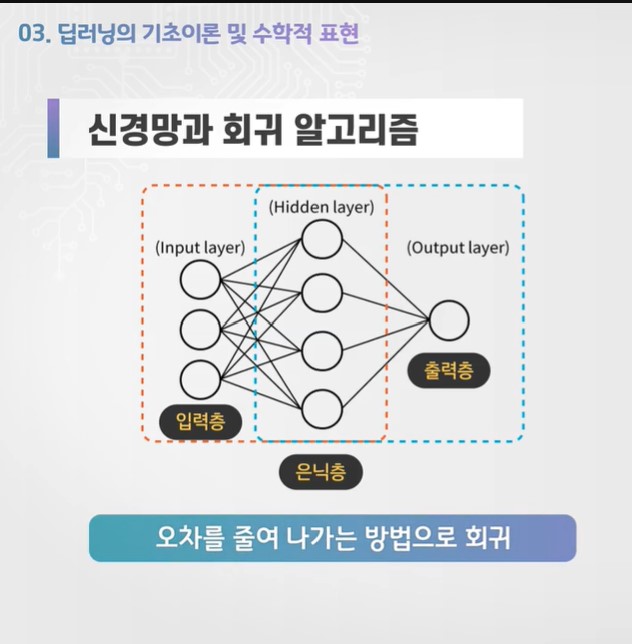

딥러닝은 AI가 실제 계산한 값과 가르쳐 준 값 간의 오차를 계속해서 줄여나가는 방법으로 회귀가 이루어짐.

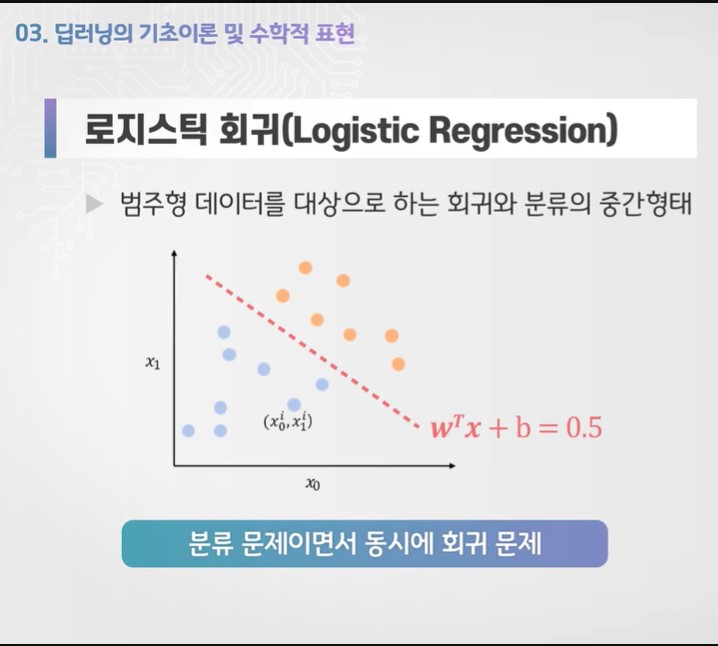

로지스틱 회귀는 한 분포도에서 선을 그어 분류와 회귀문제를 동시에 하는 것.

교차 엔트로피 오차는 평균 제곱 오차보다 훨씬 더 복잡하지만 효율이 좋은 오차 개념. 딥러닝에서 가장 많이 쓰이는 오차! 중요 개념이므로 꼭 기억.

이중 클래스 분류는 "이 동물이 개인지?" 물었을 때, "YES or NO"로만 대답이 가능하지만, 다중 클래스 분류는 "이 동물이 무엇인지?" 물었을 때, 동물에 대한 확률을 가지고 분류를 해냄. 개일 확률이 95%, 고양이일 확률이 0.7%, 말일 확률이 4% 등으로 판단해 개일 확률이 가장 높으므로 개라고 분류해내는 기술임.

그러나 컴퓨터는 '개'에 대한 개념을 알지 못하기에, 개는 0번, 고양이는 1번 등으로 레이블을 설정한다. 따라서 고양이라고 분류할 때 01 0000 이런 식으로 보여준다. 이것이 바로 '원핫 인코딩'

3-2 딥러닝 모델의 학습 및 최적화

기계학습, 머신러닝에는 3가지 종류가 있음. 지도 학습, 비지도 학습, 강화 학습

지도 학습 = 데이터를 미리 알려주고 학습이 잘 된 경우에는 학습하지 않은 데이터도 잘 추측해낼 수 있도록 학습하는 과정

비지도 학습 = "가르쳐 주지 않아도" 일반적인 데이터를 줬을 때, 데이터의 특징을 가지고 각 분야별로 쪼개며 학습하는 과정

강화 학습 = 미로를 잘 통과하면 상을 주고, 미로에서 헤매면 벌을 주는 형식의 프로그램을 짜 학습시키는 과정

지도 학습에는 사이퍼 텐 (Cifar Ten) 개념, LSTM 모델을 이용함.

사이퍼 텐은 예를 들어, 10가지의 물체에 대한 각 6만 장의 사진을 제공하고 학습을 시키는 것.

LSTM은 매일 변하는 데이터에 대해 학습을 시킬 때 사용. 주로 주가 예측이나 날씨 예측 등을 할 때 LSTM 모델 사용

손실 함수 - 학습된 출력 값이 정답과 어느 정도 차이나는 지 보여주는 지표함수. 값이 낮을수록 학습이 잘 되었고, 손실함수를 극소화 하는 것이 학습의 목표

오차 손실함수 중에서는 평균 제곱 오차, 교차 엔트로피 오차가 있는데 교차 엔트로피 오차를 자주 사용.

최적화 이론 - 무차별 대입해서 찾는 방법과 미분 값이 0이 되는 값을 찾아내는 경사 하강법을 사용. 그 외 기타 최적화 기법으로는 SGD(확률적 경사하강법), Momentum(모멘텀), Adagrad(아다그라드), RMS Prop(알엠에스 프롭), Adam(아담, Adaptive Moment Estimation)

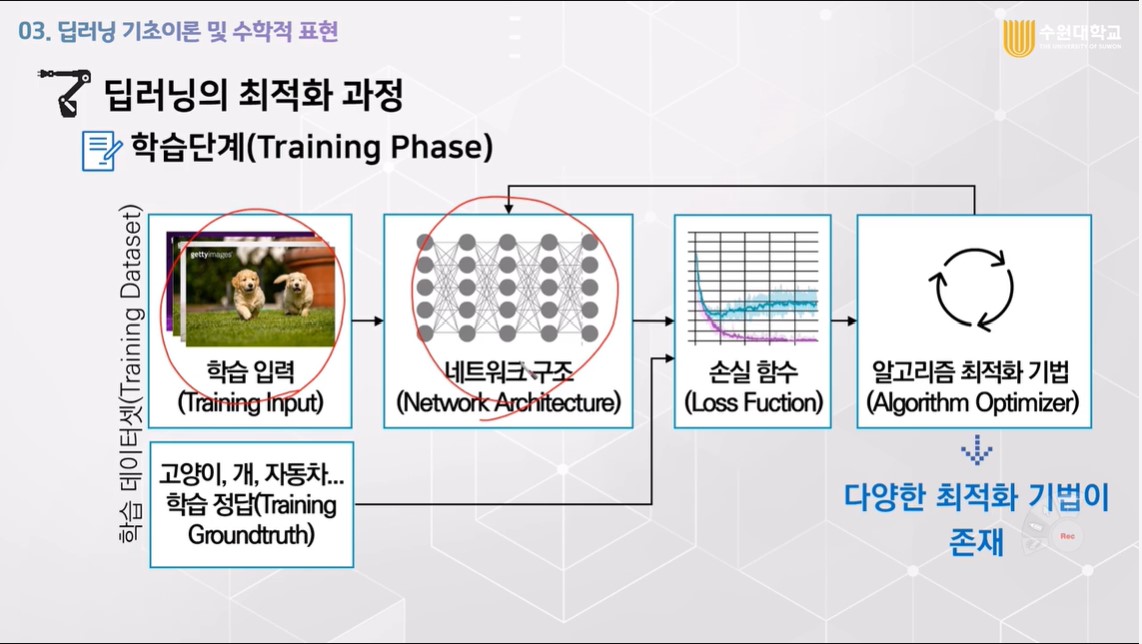

딥러닝 학습은 학습 데이터를 입력하고, 뉴럴 네트워크를 구성한 후, 손실 함수가 0이 되게끔 위의 다양한 최적화 기법(무차별 대입, 경사하강법 등)을 사용해 학습을 진행시키는 것임.

학습 후에는 가르쳐주지 않은 사진이나 자료를 보여주며 테스트하는 것임. 100개를 보여줘 99개를 맞혔다면, 99%의 정확도를 가진 인공 신경망을 만들어 내는 것임.

3-3 딥러닝 모델의 오차 역전파법

이 강의에서는 교수님께서 오차 역전파법(Backpropagation)에 대한 설명을 해주시는데, 필기를 할 수 없는 강의 내용이라..

아무튼 오차 역전파법은 인공 신경망에서 정답을 찾기 위한 최적화 기법이며, 오차 역전파 알고리즘을 통해 모든 가중치와 바이어스 값을 구해 신경망을 완성시킬 수 있다는 것에 대해 알게 되었음..

강의 마지막에 교수님께서 다음 주차부터는 파이썬과 텐서 플로우를 이용해 프로그래밍한다고 하셨음. 다음 주부턴 이론 강의보다는 실습 위주의 강의가 이루어지지 않을까 싶어 기대가 됨. 이번에 대학생 코딩 캠프로 활동하면서 파이썬, 코딩 공부를 매일 조금씩 공부하고 있는데, 써먹을 수 있다니..!!

물론 점점 더 갈수록 어려운 내용이 나오겠지만 공부했던 파이썬 코딩을 활용해 볼 수 있는 기회여서 설레기 시작함

여전히 인공지능 HRI를 들으며 수학적인 부분(오차 역전파법에 대해 설명한 부분)에서는 어려움이 많지만, 그래도 딥러닝 최적화 과정에 대해 이해하게 되어 뿌듯함.

이 글에서만큼은 포스팅 관련해서 궁금한 내용은 질문하지 마세요ㅠㅠ 저도 잘 모릅니다ㅠㅠㅠ

'대외활동 > K-MOOC 수다쟁이 4기' 카테고리의 다른 글

| 수원대학교 K-MOOC 강의 '인공지능 HRI' 5주 차 강의 후기 (0) | 2021.04.25 |

|---|---|

| K-MOOC (케이무크)로 무료로 학점은행제, 학점인정 받자! (2) | 2021.04.24 |

| 5분 안에 K-MOOC 수강 신청하고 투썸플레이스 케익기프티콘 이벤트 참여하자! (0) | 2021.03.26 |

| 수원대학교 K-MOOC 강의 '인공지능 HRI' 2주 차 강의 후기 (0) | 2021.03.16 |

| KMOOC (케이무크)로 집에서 무료로 '4차 산업혁명 등 다양한 강의'와 '국내 석학들의 강의' 듣자! (0) | 2021.03.12 |